Erstellen Sie ereignisgesteuerte Datenqualitäts-Pipelines mit AWS Glue DataBrew

Da Unternehmen immer mehr Daten sammeln, um Kernprozesse wie Entscheidungsfindung, Berichterstattung und maschinelles Lernen (ML) voranzutreiben, stoßen sie immer wieder auf schwierige Hürden! Die Sicherstellung, dass die Daten für die Verwendung geeignet sind und keine fehlenden, fehlerhaften oder falschen Inhalte enthalten, hat für viele dieser Unternehmen oberste Priorität – und genau hier kommt AWS Glue Databrew ins Spiel!

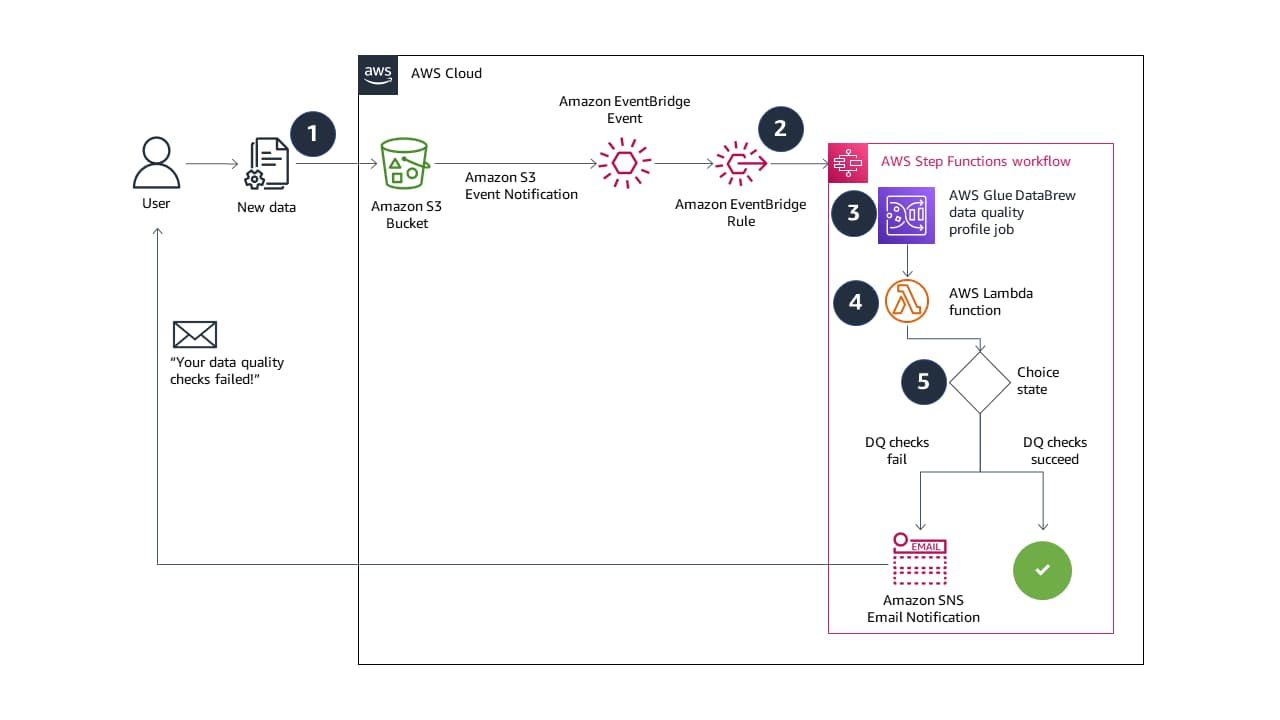

Lassen Sie uns eine vollautomatische, ereignisgesteuerte End-to-End-Pipeline für die Validierung der Datenqualität erstellen.

Das ist ein Untertitel, der uns begeistert! Wie bei jeder Datenreise ist es ein steiniger Weg, bis strukturierte, intelligente und leicht abfragbare Daten entstehen.

AWS Glue DataBrew ist ein visuelles Datenaufbereitungstool, mit dem Sie ganz einfach Datenqualitätsstatistiken wie doppelte Werte, fehlende Werte und Ausreißer in Ihren Daten finden können. Sie können in DataBrew auch Regeln für die Datenqualität einrichten, um bedingte Prüfungen auf der Grundlage spezieller Geschäftsanforderungen durchzuführen.

Metin Alisho, Data Scientist bei Firemind, sagt: „Ereignisgesteuerte Pipelines sind das ‚Brot und Butter‘ vieler unserer Kundenlösungen. Mit dieser von AWS Glue DataBrew betriebenen Lösung ist es ganz einfach, Qualitätsdaten zwischen Ausreißern und doppelten Werten zu finden.“

Transformieren Sie Ihre Daten, eine Spalte nach der anderen!

Diese Lösungen, bei denen Tools wie AWS Glue DataBrew zum Einsatz kommen, sind erst der Anfang dessen, was bei der Datenverwaltung und -auswertung möglich ist. Setzen Sie sich noch heute mit uns in Verbindung, um herauszufinden, wie wir mit Ihren Daten arbeiten können.

Kontakt aufnehmen

Möchten Sie mehr erfahren?

Haben Sie eine bestimmte Fallstudie oder einen Einblick gesehen und möchten Sie mehr erfahren? Oder denken Sie über Ihr nächstes Projekt nach? Schreiben Sie uns eine Nachricht!